Crawl Error là một thuật ngữ rất quan trọng trong lĩnh vực tối ưu hóa công cụ tìm kiếm (SEO). Nó phản ánh những khó khăn mà các công cụ tìm kiếm gặp phải khi nỗ lực truy cập và lập chỉ mục nội dung của một trang web. Việc nhận thức rõ về Crawl Error sẽ giúp bạn nâng cao hiệu suất của website mình trên các nền tảng tìm kiếm, từ đó cải thiện sự hiện diện trực tuyến của bạn.

Khi biết được các vấn đề liên quan đến Crawl Error, bạn có thể thực hiện những biện pháp cần thiết để khắc phục và tối ưu hóa trang web, góp phần thu hút nhiều lượt truy cập hơn.

Trong bài viết này, dịch vụ SEO LTGSEO xin chia sẻ thông tin Crawl Error và cách khắc phục lỗi thu thập dữ liệu chi tiết!

Danh mục bài viết

- I. Crawl Error là gì?

- II. Nguyên nhân gây ra Crawl Error

- III. Cách phát hiện Crawl Error trên website

- IV. Hướng dẫn khắc phục Crawl Error

- V. Tác động của Crawl Error đến SEO

- VI. Công cụ kiểm tra Crawl Error hiệu quả

- VII. Các loại Crawl Error thường gặp

- VIII. Crawl Error và cách tối ưu hóa trải nghiệm người dùng

- IX. Bước đầu tiên để sửa Crawl Error

- X. Làm thế nào để ngăn chặn Crawl Error

I. Crawl Error là gì?

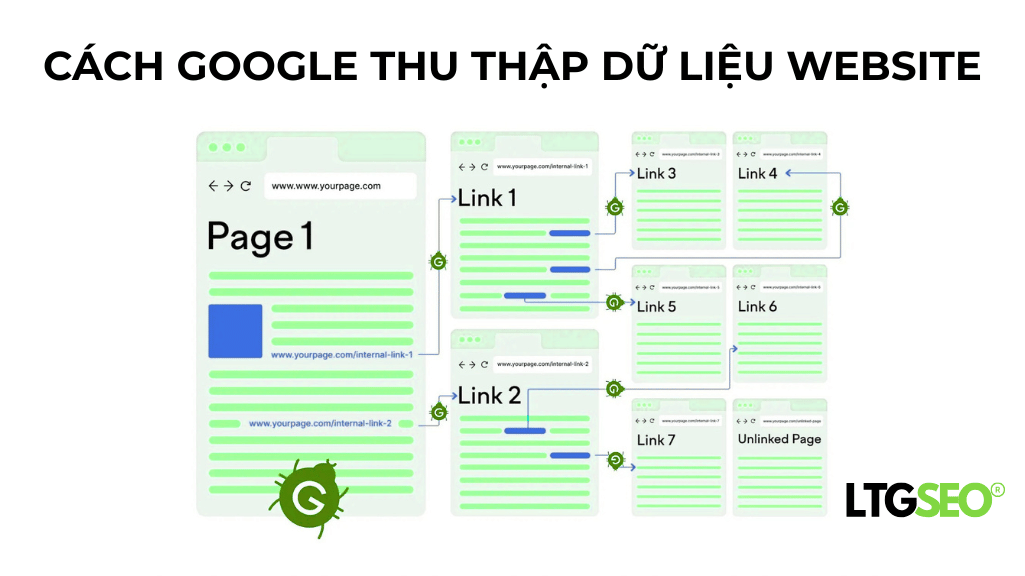

Lỗi thu thập thông tin, hay còn được gọi là Crawl Error, là một tình huống mà các công cụ tìm kiếm, đặc biệt là các bot, không thể tiếp cận hoặc lấy dữ liệu từ một trang web nào đó. Tình trạng này có thể dẫn đến việc những trang quan trọng của website không được đưa vào danh sách lập chỉ mục, từ đó làm giảm khả năng xuất hiện và hiển thị của website trên các công cụ tìm kiếm như Google. Việc này có thể ảnh hưởng nghiêm trọng đến lưu lượng truy cập và sự hiện diện trực tuyến của doanh nghiệp.

I.1. Định nghĩa cơ bản về Crawl Error

Lỗi Crawl xảy ra khi bot từ các công cụ tìm kiếm, chẳng hạn như Googlebot, không thể truy cập vào một trang web nhất định. Có nhiều lý do khác nhau dẫn đến tình trạng này, bao gồm nhưng không giới hạn ở việc URL bị hỏng, trang đã bị xóa, hoặc quyền truy cập không được thiết lập đúng cách.

Thông thường, nếu một website gặp phải nhiều lỗi Crawling, điều này có thể ảnh hưởng tiêu cực đến thứ hạng SEO của nó, bởi vì điều này có thể khiến cho các công cụ tìm kiếm không thể phát hiện và lập chỉ mục những yếu tố quan trọng của trang web.

I.2. Phân loại Crawl Error

Crawl Error được phân chia thành nhiều dạng khác nhau, tùy thuộc vào nguyên nhân gây ra cũng như đặc điểm của từng loại lỗi. Một số dạng phổ biến mà bạn có thể gặp phải bao gồm:

- Lỗi 404: Trang không tìm thấy.

- Lỗi máy chủ: Server không phản hồi lại yêu cầu từ người dùng.

- Lỗi kết nối: Không thể thiết lập kết nối tới server.

Sự phân loại này mang lại lợi ích cho các quản trị viên web, giúp họ dễ dàng hơn trong việc nhận diện và xử lý từng loại lỗi một cách hiệu quả nhất.

I.3. Sự cần thiết của việc theo dõi Crawl Error

Việc theo dõi và phân tích các lỗi khi thu thập dữ liệu (Crawl Error) là một yếu tố cực kỳ quan trọng đối với mọi chuyên gia làm SEO. Nếu những lỗi này không được khắc phục kịp thời, trang web của bạn có thể không xuất hiện trong các kết quả tìm kiếm, điều này sẽ dẫn đến việc bạn mất đi lượng lưu lượng truy cập quý giá từ người dùng. Hơn nữa, những lỗi này còn có thể ảnh hưởng tiêu cực đến trải nghiệm của người dùng, gây ra sự giảm sút trong tỷ lệ giữ chân khách hàng.

Chính vì thế, việc xử lý các lỗi này một cách nhanh chóng và hiệu quả là điều cần thiết để bảo đảm rằng trang web hoạt động tốt và thu hút được nhiều người truy cập hơn.

II. Nguyên nhân gây ra Crawl Error

Có vô số lý do dẫn đến việc xảy ra lỗi khi thu thập thông tin trên website. Việc nắm bắt và hiểu rõ những nguyên nhân này sẽ giúp bạn tìm ra những phương pháp khắc phục hiệu quả, từ đó bảo vệ và duy trì thứ hạng của website trong các kết quả tìm kiếm một cách tốt nhất.

II.1. Chuyển hướng không chính xác

Khi bạn thực hiện việc chuyển hướng giữa các URL, nếu như không cài đặt một cách chính xác, thì bot tìm kiếm có thể sẽ không tiếp cận được trang đích mà bạn mong muốn. Tình trạng này thường xảy ra khi bạn thay đổi cấu trúc của các URL nhưng lại quên không cập nhật các liên kết nội bộ hoặc không áp dụng đúng cách chuyển hướng 301.

Nếu như việc chuyển hướng không hoạt động đúng, bot sẽ gặp phải thông báo lỗi và do đó sẽ không thể tiếp tục quá trình thu thập thông tin từ trang web của bạn. Để khắc phục vấn đề này, bạn cần chắc chắn rằng tất cả các liên kết đều dẫn đến địa chỉ chính xác và không tồn tại vòng lặp chuyển hướng nào.

II.2. URL bị hỏng

Một nguyên nhân thường gặp khác dẫn đến lỗi khi thu thập thông tin (Crawl Error) là khi địa chỉ URL của trang web không còn hoạt động hoặc không tồn tại. Điều này có thể xảy ra nếu bạn đã xóa một trang nào đó hoặc thay đổi tên miền mà không cập nhật các liên kết bên trong tương ứng. Các bot tìm kiếm sẽ cố gắng truy cập vào những URL không hợp lệ và dẫn đến việc phát sinh lỗi 404.

Để tránh tình trạng này, bạn nên thực hiện việc kiểm tra định kỳ các liên kết nội bộ trên trang của mình và nhanh chóng khắc phục bất kỳ liên kết nào bị hỏng. Hành động này không chỉ giúp cải thiện khả năng thu thập thông tin của các bot tìm kiếm mà còn mang lại trải nghiệm tốt hơn cho người sử dụng trang web.

II.3. Cấu hình tệp Robots.txt sai lệch

Tệp Robots.txt là một công cụ rất quan trọng giúp bạn quản lý quyền truy cập của các bot tìm kiếm vào từng phần của trang web. Nếu như tệp này không được cấu hình đúng cách, có thể dẫn đến việc một số khu vực trên trang web sẽ bị ngăn chặn, khiến cho các bot không thể thu thập thông tin cần thiết. Điều này có thể gây ra tình trạng những trang quan trọng không được chỉ mục, từ đó ảnh hưởng tiêu cực đến hiệu suất SEO của website.

Vì vậy, hãy đảm bảo rằng bạn đã thiết lập tệp Robots.txt một cách chính xác để cho phép các bot tìm kiếm thu thập thông tin từ những trang mà bạn mong muốn đưa vào danh sách chỉ mục.

III. Cách phát hiện Crawl Error trên website

Phát hiện và xác định Crawl Error là bước đầu tiên để khắc phục chúng. Có nhiều phương pháp và công cụ để giúp bạn nhận diện các lỗi này một cách hiệu quả.

III.1. Sử dụng Google Search Console

Google Search Console là một công cụ miễn phí đầy sức mạnh mà Google cung cấp nhằm giúp các quản trị viên web theo dõi và đánh giá tình trạng hoạt động của trang web. Bằng việc sử dụng công cụ này, bạn có thể kiểm tra các báo cáo liên quan đến lỗi thu thập thông tin (Crawl Error), từ đó nhận diện những trang gặp phải vấn đề cũng như tìm ra nguyên nhân cụ thể dẫn đến các lỗi đó.

Ngoài ra, qua Google Search Console, bạn còn có khả năng yêu cầu Google thực hiện việc thu thập lại thông tin cho các trang đã được sửa chữa. Đây chính là một phương pháp đơn giản nhưng vô cùng hiệu quả để nâng cao tốc độ lập chỉ mục cho website của bạn.

III.2. Kiểm tra log server

Việc kiểm tra nhật ký máy chủ là một phương pháp hữu ích giúp bạn theo dõi cách mà các bot tìm kiếm tương tác với website của bạn. Thông qua việc phân tích những dữ liệu được ghi lại trong nhật ký máy chủ, bạn có khả năng xác định rõ ràng các URL nào đang gặp phải vấn đề lỗi và từ đó tìm ra nguyên nhân cụ thể của chúng.

Dù rằng quá trình này có thể tiêu tốn một khoảng thời gian nhất định, nhưng nó sẽ mang lại cho bạn cái nhìn sâu sắc hơn về cách mà các bot thực hiện nhiệm vụ của mình trên trang web của bạn. Từ những thông tin quý giá đó, bạn có thể đưa ra những giải pháp khắc phục phù hợp và hiệu quả hơn cho website của mình.

III.3. Sử dụng các công cụ kiểm tra SEO

Bên cạnh Google Search Console, còn rất nhiều công cụ SEO khác mà bạn có thể sử dụng như Screaming Frog, SEMrush hay Ahrefs. Những công cụ này có khả năng giúp bạn phát hiện ra các lỗi liên quan đến việc thu thập dữ liệu (Crawl Error). Chúng cung cấp các báo cáo chi tiết về tình trạng của từng trang trên website, từ đó hỗ trợ bạn trong việc nhanh chóng nhận diện và khắc phục những vấn đề gặp phải.

Các công cụ SEO này thường được thiết kế với giao diện thân thiện và dễ sử dụng, cho phép bạn tự động quét toàn bộ website. Điều này không chỉ giúp bạn tiết kiệm thời gian mà còn giảm bớt sức lực cần thiết để quản lý và tối ưu hóa nội dung của mình một cách hiệu quả hơn.

IV. Hướng dẫn khắc phục Crawl Error

Sau khi đã phát hiện được Crawl Error, việc tiếp theo là tiến hành khắc phục. Có nhiều phương pháp khác nhau để giải quyết từng loại lỗi và mỗi phương pháp đều cần được áp dụng một cách cẩn thận.

IV.1. Xử lý lỗi 404

Để xử lý lỗi 404 một cách hiệu quả, bạn cần thực hiện các bước sau đây:

- Kiểm tra và điều chỉnh liên kết: Hãy chắc chắn rằng tất cả các liên kết nội bộ đều dẫn đến các trang hợp lệ và không gặp phải vấn đề nào.

- Sử dụng chuyển hướng 301: Nếu một trang đã bị xóa hoặc không còn tồn tại, hãy thiết lập chuyển hướng 301 tới một trang tương tự hoặc quay về trang chính của website để duy trì trải nghiệm người dùng.

- Tạo trang 404 tùy chỉnh: Trang lỗi 404 nên được thiết kế sao cho hữu ích đối với người truy cập, cung cấp cho họ các tùy chọn như trở về trang chủ hoặc tìm kiếm thông tin khác trên website.

Khắc phục lỗi 404 không chỉ là việc tối ưu hóa SEO mà còn mang lại trải nghiệm tốt hơn cho người dùng khi họ truy cập vào website của bạn.

IV.2. Khắc phục các lỗi máy chủ

Lỗi máy chủ thường xuất phát từ việc cấu hình không đúng hoặc tình trạng quá tải. Để khắc phục vấn đề này, bạn có thể thực hiện các bước sau:

- Xem xét lại cấu hình của server: Hãy chắc chắn rằng cấu hình của máy chủ là chính xác và có đủ tài nguyên để xử lý lưu lượng truy cập một cách hiệu quả.

- Theo dõi hiệu suất của server: Áp dụng các công cụ giám sát để theo dõi hiệu suất hoạt động của server, giúp phát hiện kịp thời các vấn đề có thể xảy ra.

Việc sửa chữa lỗi máy chủ là cực kỳ quan trọng để đảm bảo website luôn sẵn sàng hoạt động và duy trì tốc độ truy cập tốt.

IV.3. Tối ưu hóa tệp Robots.txt

Nếu tệp Robots.txt của bạn đang cản trở các bot tìm kiếm tiếp cận những trang quan trọng, hãy thực hiện điều chỉnh cấu hình cho phù hợp.

- Cho phép bot truy cập vào các trang cần thiết: Đảm bảo rằng tất cả các trang mà bạn mong muốn được bot lập chỉ mục đều không bị chặn lại.

- Thực hiện kiểm tra lại: Sau khi đã thực hiện thay đổi, hãy sử dụng Google Search Console để xác nhận rằng bot có thể truy cập vào các trang đó.

Tối ưu hóa tệp Robots.txt có thể mang lại sự cải thiện đáng kể trong khả năng lập chỉ mục của website của bạn.

V. Tác động của Crawl Error đến SEO

Crawl Error có thể mang lại nhiều tác động tiêu cực đến SEO của website. Chúng không chỉ ảnh hưởng đến khả năng lập chỉ mục mà còn có thể tác động đến trải nghiệm người dùng và danh tiếng của thương hiệu.

V.1. Giảm khả năng lập chỉ mục

Khi mà bot tìm kiếm gặp phải nhiều lỗi thu thập dữ liệu, khả năng lập chỉ mục của trang web sẽ bị ảnh hưởng tiêu cực. Điều này có thể dẫn đến tình trạng các trang quan trọng không hiện diện trong danh sách kết quả tìm kiếm, từ đó làm giảm lượng truy cập tự nhiên mà website nhận được.

Ngược lại, nếu một trang không được lập chỉ mục, nó sẽ hoàn toàn không thể tạo ra bất kỳ lưu lượng truy cập nào từ các công cụ tìm kiếm, gây tổn hại tới hiệu suất tổng thể của website.

V.2. Ảnh hưởng đến trải nghiệm người dùng

Crawl Error có thể gây ra những trải nghiệm không tốt cho người dùng, đặc biệt khi họ cố gắng truy cập vào các trang đã không còn tồn tại. Khi một trang báo lỗi 404 hoặc không thể tải được, điều này có thể khiến người dùng cảm thấy thất vọng và quyết định rời khỏi website của bạn.

Hệ quả là, điều này sẽ tạo ra một ấn tượng tiêu cực về thương hiệu của bạn và dẫn đến việc mất đi những khách hàng tiềm năng. Vì lý do đó, việc xử lý các Crawl Error là vô cùng quan trọng, không chỉ đối với SEO mà còn cho mối quan hệ với khách hàng.

V.3. Tác động đến uy tín của website

Các vấn đề liên quan đến việc thu thập thông tin kéo dài mà không được giải quyết kịp thời có thể làm giảm đáng kể đánh giá của các công cụ tìm kiếm về chất lượng website. Hệ quả là website có nguy cơ không được liệt kê trong danh sách những trang web đáng tin cậy, từ đó gây ảnh hưởng tiêu cực đến thứ hạng tìm kiếm của nó.

Để bảo đảm rằng website duy trì được độ uy tín cao, rất cần thiết phải tiến hành theo dõi thường xuyên và xử lý kịp thời các lỗi thu thập thông tin.

VI. Công cụ kiểm tra Crawl Error hiệu quả

Có nhiều công cụ khác nhau mà bạn có thể sử dụng để kiểm tra Crawl Error trên website của mình. Mỗi công cụ đều có những ưu điểm và tính năng riêng, giúp dễ dàng nhận diện và khắc phục các lỗi.

VI.1. Google Search Console

Như đã nêu ở các phần trước, Google Search Console được coi là một trong những công cụ hữu hiệu nhất để giám sát tình trạng hoạt động của trang web. Công cụ này không chỉ cung cấp các báo cáo liên quan đến lỗi thu thập dữ liệu mà còn cho phép bạn gửi yêu cầu lập chỉ mục cho những trang mà bạn đã thực hiện sửa chữa.

Hơn nữa, Google Search Console cũng mang lại cho bạn những thông tin quý giá về hiệu suất tìm kiếm, từ đó giúp bạn có cái nhìn sâu sắc hơn về cách mà người dùng tìm kiếm và tương tác với trang web của bạn.

VI.2. Screaming Frog

Screaming Frog là một công cụ quét SEO cực kỳ hiệu quả, cho phép bạn thực hiện việc quét toàn bộ trang web để phát hiện các lỗi liên quan đến Crawl. Nó có khả năng nhận diện các lỗi 404, lỗi từ máy chủ và những vấn đề liên quan đến liên kết nội bộ.

Bên cạnh đó, công cụ này cũng mang lại những báo cáo chi tiết về các thẻ meta, tiêu đề và mô tả, góp phần không nhỏ vào việc tối ưu hóa nội dung cho mục đích SEO.

VI.3. Ahrefs

Ahrefs là một công cụ SEO mạnh mẽ và toàn diện, không chỉ đơn thuần giúp bạn kiểm tra các lỗi khi thu thập dữ liệu từ trang web, mà còn hỗ trợ phân tích các liên kết trở lại (backlink), từ khóa cũng như đối thủ cạnh tranh của bạn. Với tính năng Kiểm Tra Trang Web (Site Audit), bạn có thể quét toàn bộ website của mình và nhận được báo cáo chi tiết về những lỗi mà trang gặp phải.

Hơn nữa, Ahrefs còn cung cấp các thông tin quý giá liên quan đến hiệu suất của từ khóa, cho phép bạn theo dõi vị trí của website trong các kết quả tìm kiếm một cách hiệu quả.

VII. Các loại Crawl Error thường gặp

Khi theo dõi và kiểm tra trang web, bạn có thể gặp phải nhiều loại Crawl Error khác nhau. Mỗi loại lỗi có nguyên nhân và cách khắc phục riêng, và hiểu rõ chúng là rất quan trọng để bảo vệ SEO của bạn.

VII.1. Lỗi 404 – Trang không tìm thấy

Lỗi 404 là một trong những loại lỗi thu thập dữ liệu (Crawl Error) thường gặp nhất. Lỗi này xảy ra khi người dùng hoặc các bot tìm kiếm cố gắng truy cập vào một trang web đã bị xóa hoặc không còn tồn tại nữa.

Để khắc phục tình trạng này, bạn nên thực hiện việc kiểm tra và sửa chữa các liên kết hỏng, thiết lập chuyển hướng 301 cho những trang đã bị xóa, và đồng thời tạo ra một trang 404 tùy chỉnh giúp người dùng có thể dễ dàng tìm thấy các nội dung khác mà họ đang tìm kiếm.

VII.2. Lỗi máy chủ 500

Lỗi máy chủ 500 thường xuất hiện khi mà máy chủ không thể thực hiện yêu cầu của người dùng do gặp phải một số vấn đề về kỹ thuật hoặc có thể do cấu hình không chính xác. Tình trạng này có thể phát sinh từ việc mã nguồn của ứng dụng gặp lỗi, hoặc thậm chí là do máy chủ bị quá tải, không đủ khả năng đáp ứng nhu cầu của người sử dụng.

Để sửa chữa lỗi này, bạn cần tiến hành kiểm tra lại mã nguồn của ứng dụng để đảm bảo rằng không có lỗi xảy ra trong quá trình lập trình. Đồng thời, cũng cần xem xét lại cấu hình của máy chủ để chắc chắn rằng nó đã được thiết lập một cách chính xác nhằm phục vụ cho lưu lượng truy cập mà ứng dụng đang xử lý.

VII.3. Lỗi DNS

Lỗi DNS xảy ra khi bot không thể xác định địa chỉ IP của một trang web cụ thể. Tình trạng này có thể phát sinh do sự cố với dịch vụ DNS hoặc do cấu hình không được thiết lập chính xác.

Để giải quyết vấn đề này, bạn cần tiến hành kiểm tra lại cấu hình DNS và chắc chắn rằng tất cả các thông số đều đúng đắn và hoạt động một cách ổn định.

VIII. Crawl Error và cách tối ưu hóa trải nghiệm người dùng

Crawl Error không chỉ ảnh hưởng đến SEO mà còn có tác động lớn đến trải nghiệm người dùng. Việc tối ưu hóa để giảm thiểu các lỗi này có thể tạo ra trải nghiệm người dùng tốt hơn và giữ chân khách hàng lâu hơn.

VIII.1. Cung cấp thông tin rõ ràng

Khi người sử dụng cố gắng vào một trang web mà không còn tồn tại, việc cung cấp một trang 404 được thiết kế riêng với thông tin rõ ràng sẽ giúp họ nhận ra rằng trang đó đã không còn nữa. Hơn nữa, bạn cũng nên xem xét việc đưa ra các liên kết dẫn đến những trang khác hoặc có thể tạo một hộp tìm kiếm, điều này sẽ hỗ trợ người dùng trong việc dễ dàng tìm kiếm và thu thập thông tin mà họ đang cần tìm.

VIII.2. Tối ưu hóa cấu trúc liên kết

Một hệ thống liên kết hợp lý sẽ góp phần giảm thiểu nguy cơ xảy ra các lỗi khi thu thập thông tin từ các công cụ tìm kiếm. Cần phải đảm bảo rằng tất cả các liên kết đều được sắp xếp một cách hợp lý và không dẫn đến những trang đã không còn tồn tại. Điều này không chỉ hỗ trợ cho các bot của công cụ tìm kiếm trong việc thu thập dữ liệu mà còn mang lại trải nghiệm tốt hơn cho người dùng.

VIII.3. Thực hiện kiểm tra thường xuyên

Việc thường xuyên kiểm tra website để phát hiện các lỗi thu thập dữ liệu (Crawl Error) là điều vô cùng quan trọng. Qua việc theo dõi định kỳ, bạn sẽ có khả năng nhanh chóng nhận diện và khắc phục những vấn đề này trước khi chúng gây ảnh hưởng tiêu cực đến trải nghiệm người dùng cũng như thứ hạng SEO của trang web. Hành động này không chỉ giúp cải thiện hiệu suất của website mà còn đảm bảo rằng người dùng luôn có được trải nghiệm tốt nhất khi truy cập vào nội dung của bạn.

IX. Bước đầu tiên để sửa Crawl Error

Khi bạn phát hiện các Crawl Error, bước đầu tiên để sửa chữa là xác định chính xác loại lỗi và nguyên nhân dưới đây.

IX.1. Phân tích báo cáo từ Google Search Console

Báo cáo từ Google Search Console chính là điểm khởi đầu lý tưởng để bạn có thể nhận diện các lỗi thu thập dữ liệu (Crawl Error). Tại đây, bạn sẽ dễ dàng theo dõi danh sách những trang web gặp phải sự cố cùng với nguyên nhân cụ thể gây ra những lỗi đó.

IX.2. Kiểm tra liên kết nội bộ

Khi đã xác định những trang web gặp phải sự cố, điều quan trọng là bạn cần nhanh chóng tiến hành kiểm tra các liên kết nội bộ. Việc này nhằm đảm bảo rằng không có đường dẫn nào dẫn đến những trang đã không còn tồn tại nữa. Hãy chắc chắn rằng tất cả các liên kết đều hoạt động bình thường để tránh gây khó khăn cho người dùng và cải thiện trải nghiệm truy cập trên website của bạn.

IX.3. Thiết lập kế hoạch khắc phục

Cuối cùng, bạn nên xây dựng một kế hoạch khắc phục chi tiết cho mỗi loại lỗi mà bạn đã phát hiện. Việc này sẽ hỗ trợ bạn trong việc tổ chức công việc một cách có hệ thống và đảm bảo rằng mọi vấn đề đều được xử lý một cách kịp thời, tránh để chúng trở thành những trở ngại lớn hơn trong quá trình thực hiện.

X. Làm thế nào để ngăn chặn Crawl Error

Ngăn chặn lỗi Crawl Error là một yếu tố cực kỳ quan trọng trong quá trình tối ưu hóa website của bạn. Bằng cách thực hiện những bước cần thiết và hợp lý, bạn có thể giảm thiểu đáng kể khả năng xuất hiện các lỗi này, từ đó cải thiện hiệu suất và trải nghiệm người dùng trên trang web của mình.

X.1. Kiểm tra định kỳ

Việc thực hiện kiểm tra định kỳ là một phương pháp hiệu quả để phát hiện và khắc phục các lỗi, từ đó ngăn chặn những sự cố liên quan đến Crawl Error. Bạn có thể sử dụng những công cụ hữu ích như Google Search Console và Screaming Frog nhằm theo dõi và đánh giá tình trạng của trang web một cách chặt chẽ hơn. Những công cụ này sẽ giúp bạn nhanh chóng nhận diện vấn đề và đưa ra những giải pháp kịp thời, đảm bảo cho website hoạt động ổn định và tối ưu.

X.2. Cập nhật nội dung thường xuyên

Việc thường xuyên cập nhật nội dung không chỉ mang lại lợi ích cho SEO mà còn có tác dụng tích cực trong việc giảm thiểu các lỗi thu thập dữ liệu (Crawl Error). Khi bạn thực hiện thay đổi hoặc gỡ bỏ một trang nào đó, cần phải đảm bảo rằng các liên kết nội bộ cùng với những chuyển hướng được điều chỉnh và cập nhật ngay lập tức để tránh gây rắc rối cho quá trình truy cập của người dùng và công cụ tìm kiếm.

X.3. Đào tạo đội ngũ nhân viên

Nếu bạn sở hữu một đội ngũ quản trị viên web hoặc nhân viên làm việc trong lĩnh vực này, điều quan trọng là hãy hướng dẫn và đào tạo họ về ý nghĩa của lỗi thu thập dữ liệu (Crawl Error) cũng như cách thức nhận diện và xử lý những vấn đề này một cách hiệu quả. Một đội ngũ có kiến thức vững chắc về vấn đề này sẽ góp phần rất lớn vào việc duy trì website của bạn ở trong tình trạng tối ưu nhất, từ đó nâng cao trải nghiệm người dùng và cải thiện thứ hạng trên các công cụ tìm kiếm.

Hãy đầu tư vào việc đào tạo đội ngũ của bạn để họ có thể nắm vững những kỹ năng cần thiết nhằm đảm bảo rằng website luôn hoạt động trơn tru và hiệu quả.

Thông qua bài viết “Crawl Error là gì? 3+ Cách khắc phục lỗi thu thập dữ liệu” của LTGSEO Agency đã cho thấy Crawl Error là một trong những vấn đề thường gặp mà bất kỳ người quản trị website nào cũng có thể phải đối mặt. Tuy nhiên, nếu bạn phát hiện ra lỗi này và tiến hành khắc phục ngay lập tức, thì có khả năng cao bạn sẽ bảo vệ được thứ hạng của website trong kết quả tìm kiếm, đồng thời nâng cao trải nghiệm cho người dùng.

Vì vậy, việc thường xuyên theo dõi và kiểm tra trạng thái của website là điều rất quan trọng để đảm bảo rằng không có lỗi thu thập dữ liệu nào ảnh hưởng tiêu cực đến SEO của bạn. Bằng cách áp dụng những phương pháp cũng như công cụ phù hợp, bạn không chỉ có thể tối ưu hóa hiệu suất của website mà còn xây dựng được uy tín vững bền trên môi trường trực tuyến.

Bài viết liên quan: